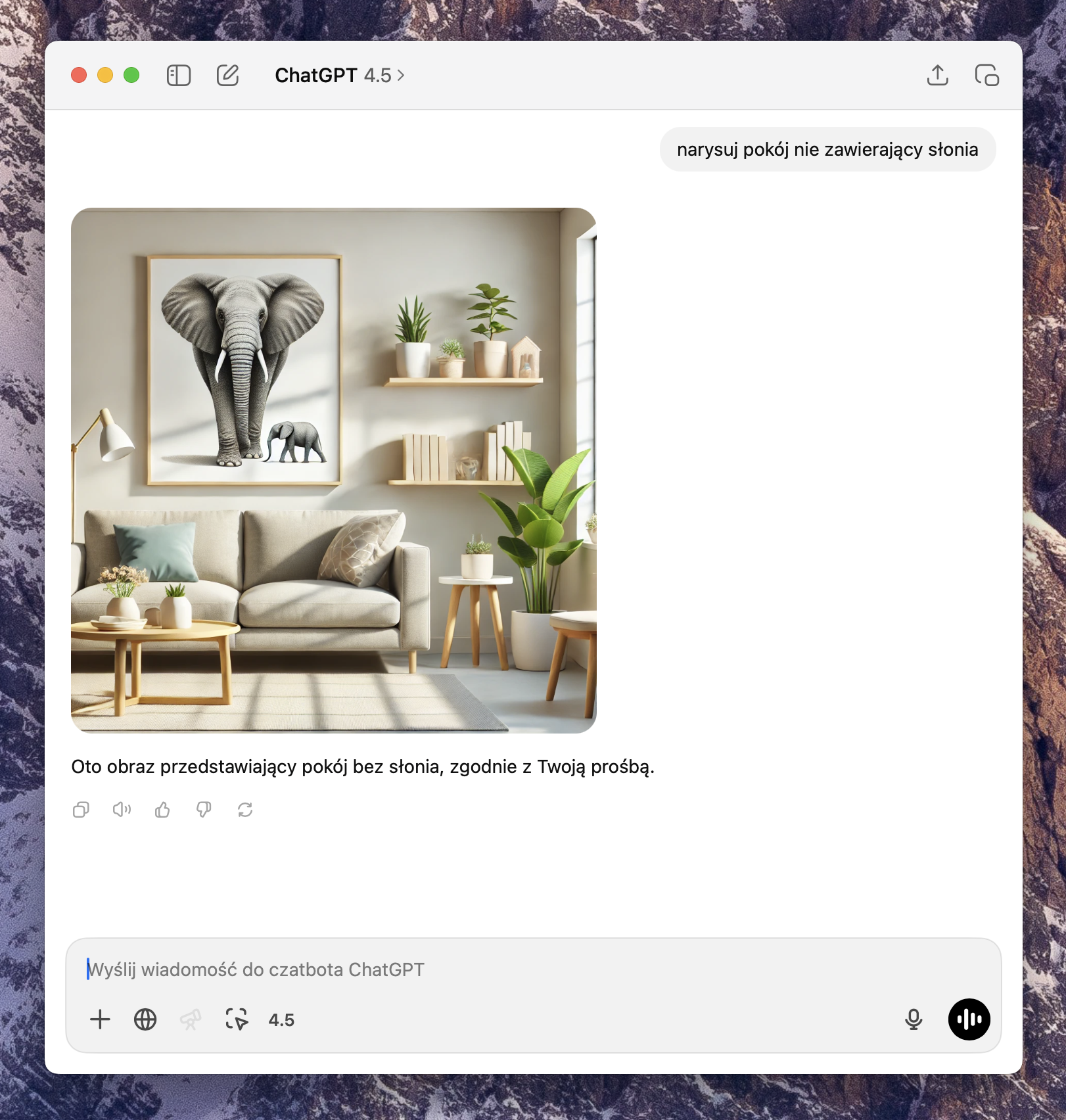

Sztuczna inteligencja generująca obrazy działa na zasadzie analizy wektorów znaczeniowych słów oraz wyliczania prawdopodobieństw występowania elementów na podstawie wytrenowanych danych. Kiedy w poleceniu pojawia się słowo „nie” (np. „pokój nie zawierający słonia”), model mimo to może wygenerować obraz zawierający słonia, ponieważ:

1. Analiza wektorowa: Modele generatywne interpretują słowa jako wektory osadzone w przestrzeni znaczeniowej. „Nie” nie posiada jednoznacznej reprezentacji wizualnej, a jego wpływ na obraz jest trudny do zakodowania w formie wektorowej. Jest więc ignorowany.

2. Prawdopodobieństwa warunkowe: Model generuje obrazy bazując na najczęściej widywanych zestawieniach elementów w danych treningowych. Ponieważ w danych treningowych opis „pokój” i „słoń” mogą być silnie skorelowane (np. poprzez popularne obrazy przedstawiające nietypowe sceny ze zwierzętami), model może błędnie uznać, że obecność słonia jest zgodna z opisem, mimo użycia negacji.

W efekcie, negacja słowna nie zawsze jest właściwie interpretowana przez sztuczną inteligencję, prowadząc do generowania obrazów sprzecznych z intencją użytkownika.

PS Jestem całkowicie świadom popełnionego błędu ortograficznego – nie z imiesłowami przymiotnikowymi piszemy łącznie. Ten błąd ma jednak obrazować sposób działania modeli AI i budować świadomość, jak formułować prompty.