Blisko tydzień temu Apple zaprezentowało nowy, ujednolicony język designu dla wszystkich swoich platform. Pozbyło się tym samym bałaganu, który zaczął powodować, że doświadczenia z użytkowania różnych urządzeń z ich ekosystemu były niejednolite. Celowo używam jednak określenia „język designu” zamiast „interfejs użytkownika” bo różnice nadal są, ale istotnie macOS, iPadOS czy VisionOS nigdy nie były tak blisko siebie pod względem wyglądu i mechaniki działania.

Ujednolicenie numeracji, spójny interfejs, przenikające się SDK… mógłbym próbować streścić i opowiedzieć cały tydzień WWDC 25, ale nie o tym miał być ten wpis.

Rys historyczny

Geneza tzw. „liquid design” (marketingowo nazwany dziś Liquid Glass) prowadzi prosto do visionOS: pierwsze półprzezroczyste warstwy interfejsu pokazano publicznie wraz z prezentacją Apple Vision Pro na WWDC 2023, a Alan Dye podkreśla, że zdecydowana większość koncepcji zrodziła się właśnie podczas wieloletnich prac nad systemem dla gogli Apple. Sam headset był przedsięwzięciem bez precedensu w historii firmy — Apple rozpoczęło projekt zaraz po przejęciu Metaio w maju 2015 r., tworząc specjalny Technology Development Group i składając w kolejnych latach ponad 5 000 zgłoszeń patentowych; oznacza to blisko dekadę rozwoju (raporty wskazują start „późną jesienią 2015 r.”) przed publicznym debiutem urządzenia w czerwcu 2023 roku. W praktyce więc sam interfejs, który dziś trafia na iPhone’a, Maca czy Apple Watch, powstawał równolegle z pierwszymi prototypami Vision Pro i dopiero po sprawdzianie w środowisku przestrzennym został w 2025 r. ujednolicony dla wszystkich platform pod parasolem Liquid Glass.

Wygląd

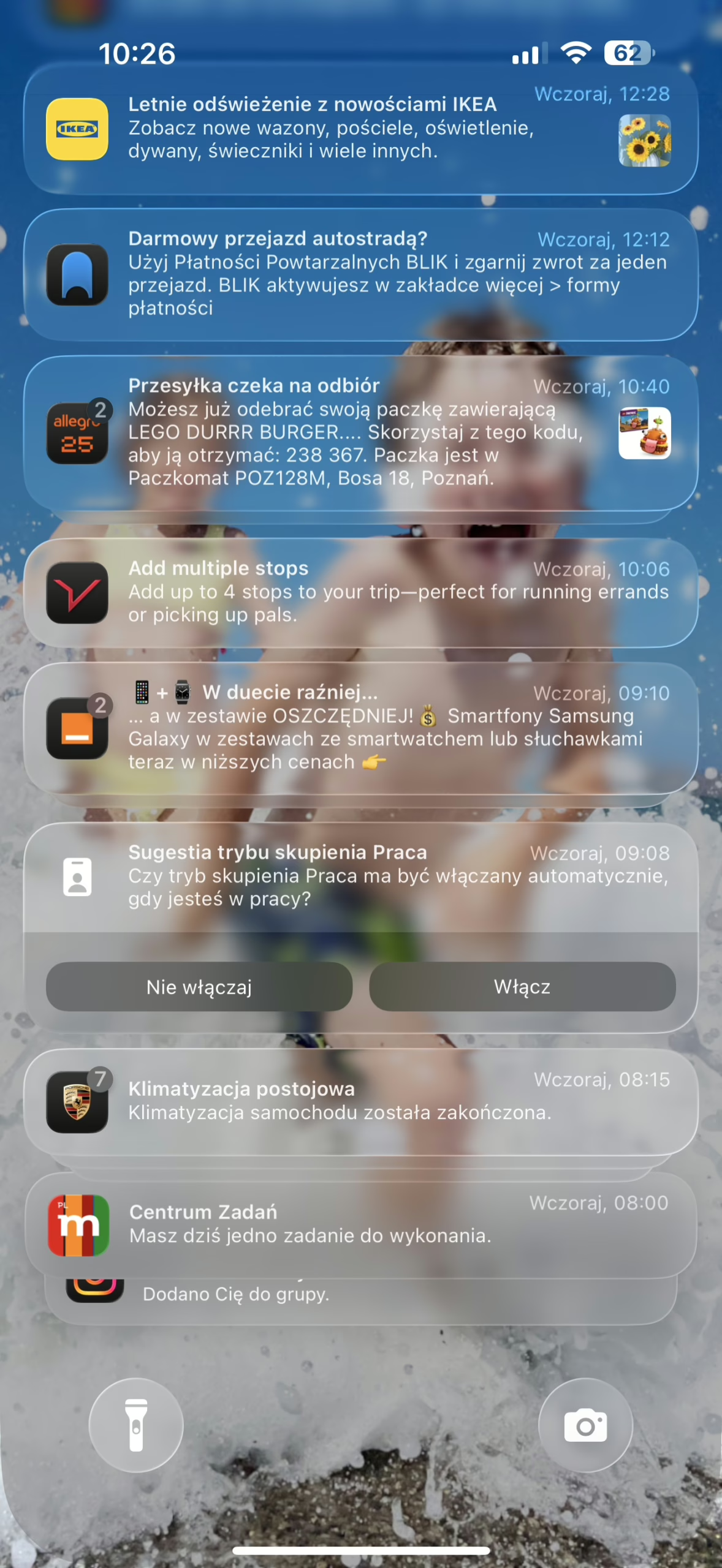

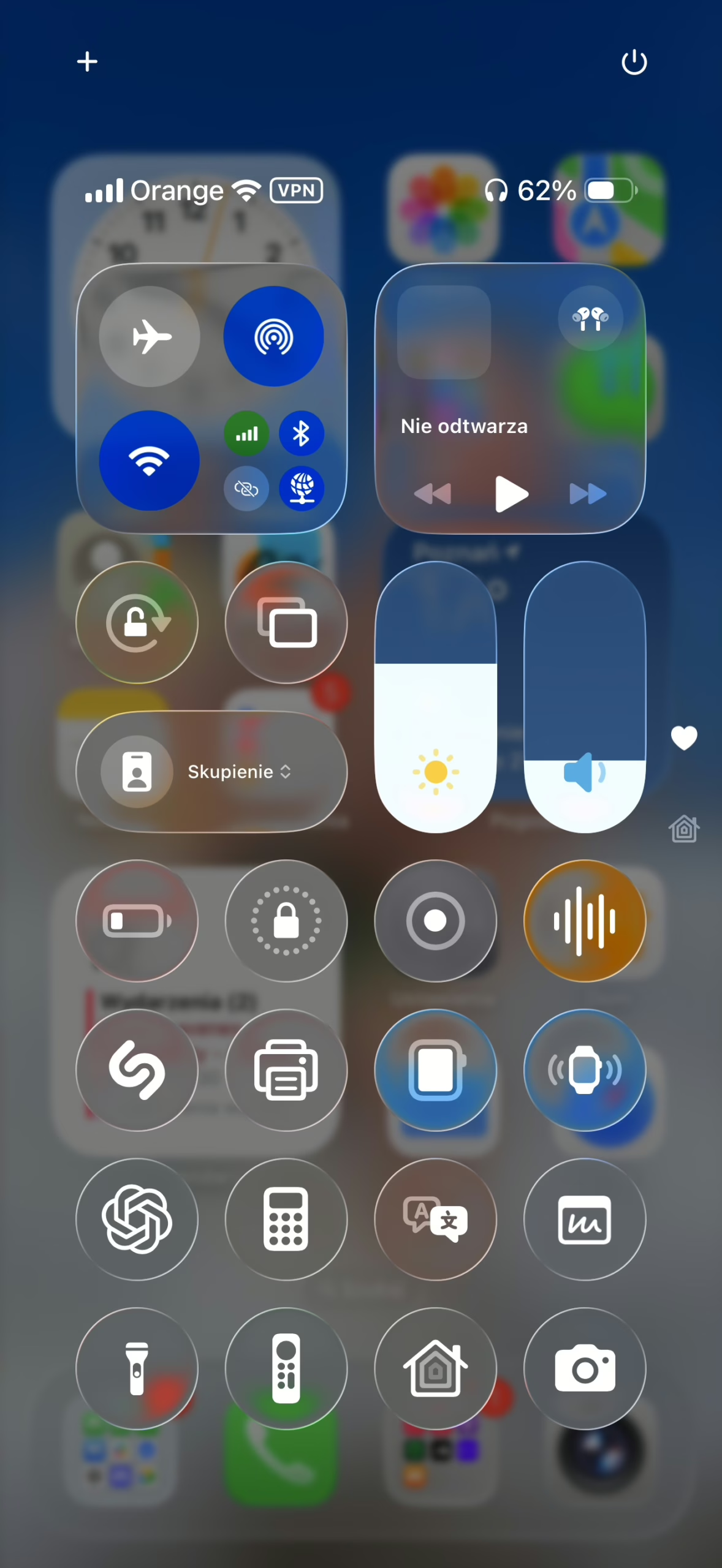

Reakcje na Liquid Glass są skrajne. Krytycy – od projektantów cytowanych przez WIRED po użytkowników dyskutujących na MacRumors – zwracają uwagę, że półprzezroczyste panele potrafią zlewać się z tapetą, a drobne fonty tracą kontrast, przez co powiadomienia czy Centrum sterowania bywają trudne do odczytania; niektórzy porównują efekty do aero z Windows Vista. Na marginesie Windows Vista znacząco wyprzedzała swoje czasy, doskonale pamiętam genialne wrażenie wizualne, które w zderzeniu z rzeczywistością, czyli mocą obliczeniową jednych z najszybszych laptopów tamtych czasów było fatalne. Jednocześnie entuzjaści widzą w nowym materiale „szklaną głębię”, która dodaje interfejsowi taktylności i życia – pochwały pojawiają się w branżowych tekstach i na Reddit, a recenzenci podkreślają, że dynamiczne załamania światła tworzą wrażenie prawdziwego szkła. W praktyce opinie pośrednie niemal nie istnieją: albo zachwyt, albo zarzut nieczytelności.

Warto jednak pamiętać, że oglądamy dopiero pierwszą deweloperską betę. Projektanci cytowani przez WIRED podpowiadają proste lekarstwo – mocniejsze rozmycie tła natychmiast poprawia kontrast – a Apple wielokrotnie korygowało właśnie ten parametr między kolejnymi kompilacjami, choćby w drodze od pierwszych wydań iOS 7 do stabilnego 7.1. TechCrunch przypomina, że podobne „niedoróbki” z czasem zniknęły, a finalne wersje stały się standardem postrzeganym dziś jako oczywisty i… ten idealny, z którego trudno przesiąść się na nowszą wersję. Wszystko wskazuje na to, że identyczny cykl dopracowywania czeka iOS 26, macOS Tahoe czy iPadOS – zanim Liquid Glass trafi do szerokiego grona użytkowników, problemy z czytelnością najpewniej zostaną wypolerowane właśnie dodatkowymi warstwami rozmycia, delikatnym przyciemnieniem, efektem bokeh czy winietowaniem.

Tajny eksperyment

Liquid Glass nie jest kolejną kosmetyczną zmianą UI – to zakrojony na niespotykaną skalę test percepcji, prowadzony w czasie rzeczywistym na setkach milionów użytkowników iPhone’ów, iPadów oraz Maców. Od iOS 26 i macOS Tahoe po visionOS 26 każda interakcja z półprzezroczystymi warstwami, refleksami światła i dynamicznym rozmyciem tła dostarcza Apple precyzyjnych danych o tym, jak szybko oko i mózg akceptują nową plastykę szkła. Wzrokowa „rehabilitacja” potrwa dokładnie dwa pełne cykle systemowe – Apple ma rok, by w wydaniach 26.x oswoić użytkowników ze szkłem, a kolejny, by w wydaniu sygnowanym wersją 27 wypolerować go, czego domagają się dziś projektanci wskazujący na przejściowe problemy z czytelnością. Badania nad reorganizacją modeli mentalnych pokazują, że gdy interfejs konsekwentnie powtarza jeden materiał wizualny, użytkownicy przebudowują nawyki percepcyjne w ciągu 12-18 miesięcy – to ewolucja w nas samych, nie tylko w pikselach.

Efekt końcowy ma zbiec się w czasie z premierą lekkich okularów AR, roboczo zwanych Apple Glass. Bloomberg podaje, że urządzenie trafi do sprzedaży „pod koniec 2026 r.”, a Tim Cook uczynił je projektem absolutnego priorytetu, determinując zasoby sprzętowe i software’owe firmy. To oznacza 18–24 miesięcy od dziś – dokładnie tyle, ile potrzeba, by dwie generacje systemów nasycone Liquid Glass wytrenowały nas do czytania tekstu na prawdziwym, przezroczystym szkle tak naturalnie, jak dziś na matrycy OLED. Stawka jest wysoka: konkurencja nie czeka. Meta sprzedała już ponad 2 miliony Ray-Ban Meta Smart Glasses i 20 czerwca pokaże sportowy model z Oakleyem, windując oczekiwania wobec tej kategorii urządzeń. Apple potrzebuje więc, by w chwili debiutu Apple Glass nowa estetyka była dla użytkowników tak oczywista, jak ikonki w docku – wtedy to, co dziś wygląda na śmiałe eksperymenty z przezroczystością, okaże się naturalnym środowiskiem, w którym tekst i grafika po prostu „pływają” w przestrzeni i pozostają doskonale czytelne.